Was ist der Unterschied zwischen Durchsatz und Latenz?

Latenz und Durchsatz sind zwei Metriken, mit denen die Leistung eines Computernetzwerks gemessen wird. Die Latenz ist die Verzögerung bei der Kommunikation im Netzwerk. Sie zeigt die Zeit an, die Daten für die Übertragung über das Netzwerk benötigen. Netzwerke mit einer längeren Verzögerung weisen eine hohe Latenz auf, während Netzwerke mit schnellen Reaktionszeiten eine geringere Latenz aufweisen. Der Begriff „Durchsatz“ bezeichnet hingegen das durchschnittliche Datenvolumen, das tatsächlich über eine bestimmte Zeit durch das Netzwerk geleitet werden kann. Er gibt an, wie viele Datenpakete an ihrem Ziel ankommen und wie viele nicht (Datenpaketverlust).

Warum sind Durchsatz und Latenz wichtig?

Sie können die Netzwerkgeschwindigkeit ermitteln, indem Sie sich ermitteln, wie schnell Datenpakete in einem Netzwerk ihre Ziele erreichen. Diese Geschwindigkeit ergibt sich aus Einflussfaktoren der Netzwerkleistung wie Latenz und Durchsatz.

Die Latenz bestimmt die Verzögerung, die Benutzer beim Senden oder Empfangen von Daten im erleben. Der Durchsatz bestimmt die Anzahl der Benutzer, die gleichzeitig auf das Netzwerk zugreifen können.

Ein Netzwerk mit niedrigem Durchsatz und hoher Latenz hat Schwierigkeiten, ein hohes Datenvolumen zu senden und zu verarbeiten, sodass es zu Überlastung und schlechter Anwendungsleistung kommt. Im Gegensatz dazu ist ein Netzwerk mit hohem Durchsatz und niedriger Latenz reaktionsschnell und effizient. Die Benutzer erleben eine bessere Leistung und sind zufriedener.

Leistungsstarke Netzwerke wirken sich direkt auf den generierten Umsatz und die operative Effizienz aus. Für optimale Funktion erfordern bestimmte Anwendungsfälle – wie Echtzeit-Streaming, Datenanalysen im Internet der Dinge (IoT) und Hochleistungsdatenverarbeitung – darüber hinaus bestimmte Schwellenwerte für die Netzwerkleistung.

Hauptunterschiede: Netzwerklatenz im Vergleich zum Durchsatz

Obwohl sowohl Latenz als auch Durchsatz zu einem zuverlässigen und schnellen Netzwerk beitragen, sind sie nicht dasselbe. Diese Netzwerkmetriken konzentrieren sich auf unterschiedliche Statistiken und unterscheiden sich voneinander.

So wird messen

Sie können die Netzwerklatenz bestimmen, indem Sie die Ping-Zeit messen. Bei einem Ping übertragen Sie ein kleines Datenpaket und erhalten die Bestätigung, dass es eingetroffen ist.

Die meisten Betriebssysteme unterstützen einen Ping-Befehl, der von Ihrem Gerät aus ausgeführt wird. Die Round-Trip-Time (RTT) wird in Millisekunden angezeigt und gibt Ihnen eine Vorstellung davon, wie lange es dauert, bis Ihr Netzwerk Daten überträgt.

Den Durchsatz können Sie mit Netzwerktesttools oder manuell messen. Wenn Sie den Durchsatz manuell testen möchten, senden Sie eine Datei und dividieren die Dateigröße durch die Zeit, die bis zum Eintreffen benötigt wird. Latenz und Bandbreite wirken sich jedoch auf den Durchsatz aus. Aus diesem Grund verwenden viele Benutzer Netzwerktesttools, denn diese Tools geben neben anderen Faktoren wie Bandbreite und Latenz auch den Durchsatz an.

Lesen Sie mehr über RTT in Netzwerken“

Maßeinheit

Die Latenz wird in Millisekunden angegeben. Wenn die Verzögerung nur wenige Millisekunden beträgt, ist die Latenz in Ihrem Netzwerk gering. Je mehr Millisekunden es dauert, desto langsamer arbeitet das Netzwerk.

Früher wurde der Netzwerkdurchsatz in Bit pro Sekunde (bps) angegeben. Da sich die Datenübertragungstechnologien verbessert haben, werden heute viel höhere Werte erreicht. Deshalb wird der Durchsatz heute in Kilobyte pro Sekunde (Kbps), Megabyte pro Sekunde (Mbit/s) und sogar in Gigabyte pro Sekunde (Gbit/s) angegeben. Ein Byte entspricht acht Bit.

Einflussfaktoren: Latenz im Vergleich zu Durchsatz

Verschiedene Faktoren können sich auf Ihre Latenz- und Durchsatzmetriken auswirken.

Latenz

Es gibt mehrere Faktoren, die dazu beitragen, ob die Latenz hoch oder niedrig ist.

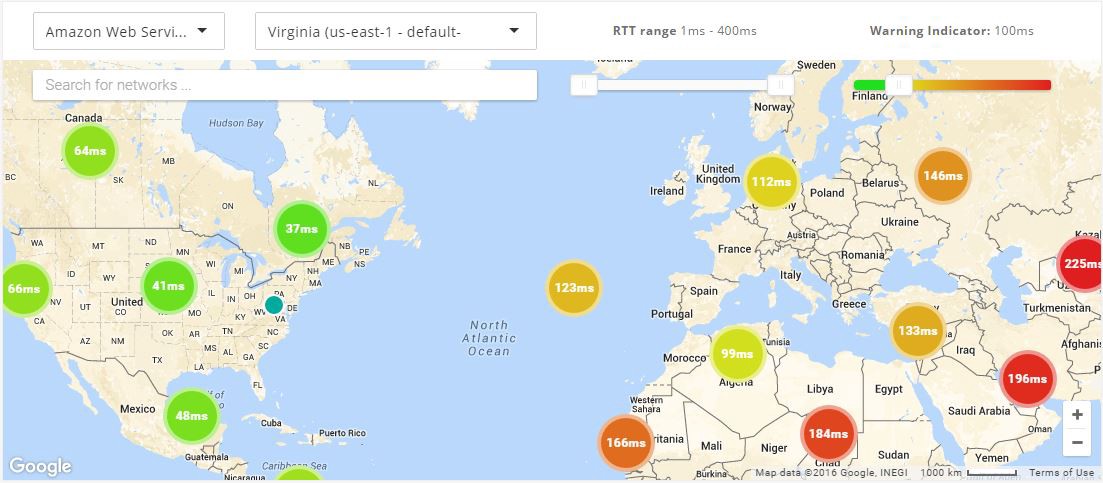

Ort

Einer der wichtigsten Faktoren ist der Ort, von dem Daten herkommen, sowie ihr gewünschtes Ziel. Wenn sich Ihre Server in einer anderen geografischen Region als Ihr Gerät befinden, müssen die Daten weiter übertragen werden, sodass die Latenz zunimmt. Dieser Faktor wird als Propagation bezeichnet.

Netzwerküberlastung

Eine Netzwerküberlastung tritt auf, wenn ein hohes Datenvolumen über ein Netzwerk übertragen wird. Der erhöhte Datenverkehr im Netzwerk führt dazu, dass Pakete längere Strecken bis zu ihrem Ziel zurücklegen.

Effizienz des Protokolls

Einige Netzwerke benötigen aus Sicherheitsgründen zusätzliche Protokolle. Die zusätzlichen Schritte für den Handshake bewirken eine Verzögerung.

Netzwerkinfrastruktur

Netzwerkgeräte können überlastet werden und auf diese Weise bewirken, dass Pakete verworfen werden. Wenn Pakete verzögert oder verworfen werden, übertragen die Geräte sie erneut. Dies erhöht die Latenz.

Durchsatz

Die Durchsatzgeschwindigkeiten werden direkt von anderen Faktoren beeinflusst.

Bandbreite

Wenn Ihre Netzwerkkapazität die maximale Bandbreite Ihres Übertragungsmediums erreicht hat, wird sein Durchsatz diese Grenze niemals überschreiten können.

Rechenleistung

Bestimmte Netzwerkgeräte verfügen über spezielle Hardware- oder Softwareoptimierungen, die ihre Verarbeitungsleistung verbessern. Beispiele hierfür sind unter anderem dedizierte anwendungsspezifische integrierte Schaltungen oder softwarebasierte Paketverarbeitungssysteme.

Diese Optimierungen ermöglichen es dem Gerät, höhere Datenverkehrsmengen und komplexere Paketverarbeitungsaufgaben zu bewältigen. Das bewirkt einen höheren Durchsatz.

Paketverlust

Zu Paketverlust kann es aus einer Vielzahl von Gründen kommen, darunter Netzwerküberlastung, fehlerhafte Hardware oder falsch konfigurierte Netzwerkgeräte. Wenn Pakete verloren gehen, müssen sie erneut übertragen werden. Dies führt zu Verzögerungen und reduziert den Gesamtdurchsatz des Netzwerks.

Netzwerktopologie

Die Netzwerktopologie bezieht sich auf die Anzahl der Netzwerkgeräte, die Bandbreite der Netzwerkverbindungen und die Entfernung zwischen Geräten in einem Netzwerkpfad.

Eine gut konzipierte Netzwerktopologie ermöglicht mehrere Pfade für die Datenübertragung, reduziert auf diese Weise Datenverkehrsengpässe und erhöht den Durchsatz. Um in Netzwerken mit mehr Geräten oder größeren Entfernungen einen hohen Durchsatz zu erreichen, sind komplexe Netzwerktopologien erforderlich.

Beziehung zwischen Bandbreite, Latenz und Durchsatz

Latenz und Durchsatz sorgen zusammen für eine hohe Netzwerkkonnektivität und Leistung. Da sich beide auf die Übertragung von Datenpaketen auswirken, beeinflussen sie sich auch gegenseitig.

Wenn eine Netzwerkverbindung eine hohe Latenz aufweist, kann sie einen geringeren Durchsatz haben, da es länger dauert, bis Daten übertragen werden und eintreffen. Ein niedriger Durchsatz erweckt zudem den Anschein, dass ein Netzwerk eine hohe Latenz hat, denn es dauert länger, bis große Datenmengen ankommen.

Da beide Faktoren eng miteinander verknüpft sind, müssen Sie sowohl die Latenz als auch den Durchsatz überwachen, damit Sie eine hohe Netzwerkleistung erzielen.

Bandbreite und Netzwerkdurchsatz

Die Bandbreite ist das Gesamtdatenvolumen, das Sie über ein Netzwerk übertragen können. Ihre Gesamtbandbreite bezeichnet die theoretische maximale Datenmenge, die Sie über ein Netzwerk übertragen könnten. Sie wird in Megabyte pro Sekunde (MBps) gemessen. Sie können sich Bandbreite als den theoretischen maximalen Durchsatz Ihres Netzwerks vorstellen.

Die Bandbreite gibt an, wie viele Daten Sie übertragen können, während der Durchsatz die tatsächliche Datenmenge ist, die Sie, basierend auf den realen Netzwerkbeschränkungen, zu einem bestimmten Zeitpunkt übertragen. Eine hohe Bandbreite garantiert keine Geschwindigkeit oder eine gute Netzwerkleistung, aber eine höhere Bandbreite kann einen höheren Durchsatz ermöglichen.

Wie können Sie die Latenz und den Durchsatz verbessern?

Um die Latenz zu verbessern, können Sie den Übertragungsweg zwischen Quelle und Ziel verkürzen. Um den Durchsatz zu verbessern, können Sie die Netzwerkbandbreite insgesamt erhöhen.

Im Folgenden machen wir Ihnen einige Vorschläge, um Latenz und Durchsatz gemeinsam zu verbessern.

Caching

Caching in Netzwerken bezeichnet einen Prozess, bei dem häufig abgerufene Daten geografisch näher am Benutzer gespeichert werden. Sie können Daten beispielsweise auf Proxyservern oder in Content Delivery Networks (CDNs) speichern.

Ihr Netzwerk kann Daten vom Speicherort des Caches viel schneller bereitstellen, als wenn sie von der ursprünglichen Quelle abgerufen werden müssten. Zugleich erhält der Benutzer die Daten viel schneller, sodass die Latenz sinkt. Da die Daten aus einem Cache abgerufen werden, wird außerdem die ursprüngliche Quelle entlastet. Dadurch können mehr Anfragen gleichzeitig bearbeitet werden, sodass der Durchsatz verbessert wird.

Transportprotokolle

Durch die Optimierung des für bestimmte Anwendungen verwendeten Transportprotokolls können Sie die Netzwerkleistung verbessern.

Zwei gängige Netzwerkprotokolle sind beispielsweise TCP und UDP. TCP stellt eine Verbindung her und überprüft, ob Sie Daten fehlerfrei empfangen. Aufgrund seines Ziels, Paketverluste zu reduzieren, weist TCP eine höhere Latenz und einen höheren Durchsatz auf. UDP sucht nicht nach Paketverlusten oder Fehlern, sondern überträgt stattdessen mehrere doppelte Pakete. Es sorgt also für eine minimale Latenz, aber einen höheren Durchsatz.

Abhängig von der Anwendung, die Sie verwenden, kann entweder TCP oder UDP die bessere Wahl sein. TCP ist beispielsweise nützlich für die Übertragung von Daten, während UDP für Videostreaming und Spiele nützlich ist.

Servicequalität

Sie können eine QoS-Strategie (Quality of Service) verwenden, um die Netzwerkleistung zu verwalten und zu optimieren. QoS ermöglicht es Ihnen, den Netzwerkverkehr in bestimmte Kategorien zu unterteilen. Sie können jeder Kategorie eine Prioritätsstufe zuweisen.

Ihre QoS-Konfigurationen priorisieren latenzsensitive Anwendungen. Bei einigen Anwendungen und Benutzern ist die Latenz geringer als bei anderen. Ihre QoS-Konfigurationen können Daten auch nach Typ priorisieren, sodass Paketverluste reduziert und der Durchsatz für bestimmte Benutzer erhöht wird.

Zusammenfassung der Unterschiede: Durchsatz im Vergleich zu Latenz

| Durchsatz |

Latenz |

|

| Was wird damit gemessen? |

Der Durchsatz misst das Datenvolumen, das in einem bestimmten Zeitraum durch ein Netzwerk fließt. Der Durchsatz wirkt sich darauf aus, wie viele Daten Sie in einem bestimmten Zeitraum übertragen können. |

Die Latenz misst die zeitliche Verzögerung beim Senden von Daten. Eine höhere Latenz bewirkt eine Netzwerkverzögerung. |

| Wie wird messen? |

Manuelle können Sie den Durchsatz berechnen, indem Sie eine Datei senden oder Tools für Netzwerktests verwenden. |

Berechnen Sie die Latenz mithilfe der Ping-Zeiten. |

| Maßeinheit |

Megabyte pro Sekunde (MBps). |

Millisekunden (ms). |

| Einflussfaktoren |

Bandbreite, Netzwerkverarbeitungsleistung, Paketverlust und Netzwerktopologie. |

Geografische Entfernungen, Netzwerküberlastung, Transportprotokoll und Netzwerkinfrastruktur. |

Wie kann AWS Ihre Anforderungen an die Netzwerkleistung unterstützen?

Amazon Web Services (AWS) bietet eine Reihe von Lösungen zur Reduzierung der Netzwerklatenz und zur Verbesserung des Netzwerkdurchsatzes an. Je nach Ihren Anforderungen können Sie einen der folgenden Dienste implementieren:

- Amazon CloudFront ist ein Service für Content Delivery Networks, der auf hohe Leistung, Sicherheit und Entwicklerkomfort ausgelegt ist. Sie können es verwenden, um Inhalte sicher mit geringer Latenz und hohen Übertragungsgeschwindigkeiten bereitzustellen.

- AWS Direct Connect ist ein Cloud-Service, der Ihr Netzwerk direkt mit AWS verbindet, um für eine einheitlichere und geringe Netzwerklatenz zu sorgen. Beim Erstellen einer neuen Verbindung können Sie eine von einem AWS Direct Connect-Bereitstellungspartner bereitgestellte gehostete Verbindung oder eine dedizierte Verbindung von AWS auswählen, um sie an über 100 AWS Direct Connect-Standorten auf der ganzen Welt bereitzustellen.

- AWS Global Accelerator ist ein Netzwerkservice, der die Datenverkehrsleistung Ihrer Benutzer durch Verwendung der globalen Netzwerkinfrastruktur von AWS um bis zu 60 % verbessert. Wenn das Internet überlastet ist, optimiert AWS Global Accelerator den Pfad zu Ihrer Anwendung, um Paketverluste, Jitter und Latenz konstant niedrig zu halten.

- AWS Local Zones sind eine Art von Infrastrukturbereitstellung, die Datenverarbeitungs-, Speicher-, Datenbank- und andere ausgewählte AWS-Services näher an große Bevölkerungs- und Industrie-Zentren heranbringen. Sie können innovative Anwendungen, die eine niedrige Latenz erfordern, näher an den Endbenutzern und auf On-Premises-Einrichtungen bereitstellen.

Beginnen Sie mit der Optimierung Ihres Durchsatzes und Ihrer Latenz auf AWS, indem Sie noch heute ein Konto erstellen.