¿Cuál es la diferencia entre rendimiento y latencia?

La latencia y el rendimiento son dos métricas que miden el desempeño de una red de computación. La latencia es el retraso en la comunicación de la red. Muestra el tiempo que tardan los datos en transferirse a través de la red. Las redes con un mayor retraso o retardo tienen una latencia alta, mientras que las que tienen tiempos de respuesta rápidos tienen una más baja. Por el contrario, el rendimiento se refiere al volumen promedio de datos que realmente pueden pasar a través de la red durante un tiempo determinado. Indica tanto la cantidad de paquetes de datos que llegan correctamente a sus destinos como los que se pierden.

¿Por qué son importantes el rendimiento y la latencia?

Puede determinar la velocidad de la red si observa la rapidez con la que una red puede transferir paquetes de datos a sus destinos. Esta velocidad es el resultado de factores de rendimiento de la red, como la latencia y el rendimiento.

La latencia determina el retraso que experimenta un usuario cuando envía o recibe datos de la red. El rendimiento determina la cantidad de usuarios que pueden acceder a la red al mismo tiempo.

Una red con bajo rendimiento y alta latencia tiene dificultades para enviar y procesar grandes volúmenes de datos, lo que provoca congestión y un rendimiento deficiente de las aplicaciones. Por el contrario, una red con alto rendimiento y baja latencia responde y es eficiente. Los usuarios experimentan un mejor rendimiento y una mayor satisfacción.

Las redes de alto rendimiento afectan directamente a la generación de ingresos y a la eficiencia operativa. Además, ciertos casos de uso, como el streaming en tiempo real, el análisis de datos de Internet de las cosas (IoT) y la computación de alto rendimiento, requieren ciertos umbrales de rendimiento de la red para funcionar de manera óptima.

Diferencias clave: latencia de red frente a rendimiento

Si bien la latencia y el rendimiento contribuyen a una red fiable y rápida, no son lo mismo. Estas métricas de red se centran en estadísticas distintas y son diferentes entre sí.

Cómo se mide

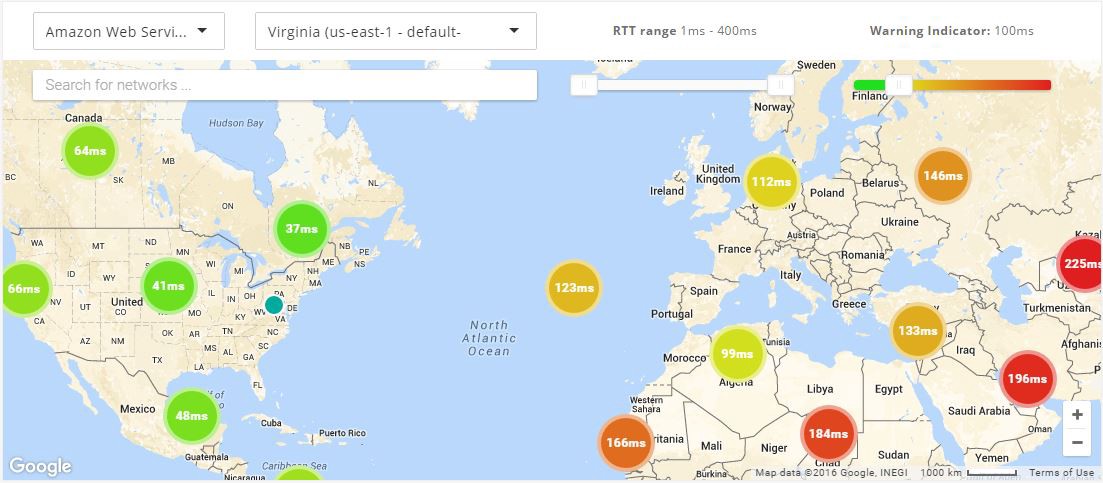

Puede medir la latencia de la red si mide el tiempo del ping. Este proceso consiste en transmitir un pequeño paquete de datos y recibir la confirmación de que ha llegado.

La mayoría de los sistemas operativos admiten un comando ping que hace el proceso desde el dispositivo. El tiempo de ida y vuelta (RTT) se muestra en milisegundos y le da una idea del tiempo que tarda la red en transferir datos.

Puede medir el rendimiento con herramientas de prueba de red o de forma manual. Si quisiera probar el rendimiento manualmente, debería enviar un archivo y dividir el tamaño del archivo por el tiempo que tarda en llegar. Sin embargo, la latencia y el ancho de banda afectan al rendimiento. Por ello, muchas personas utilizan herramientas de prueba de red, ya que las herramientas informan del rendimiento junto con otros factores como el ancho de banda y la latencia.

Más información sobre el RTT en redes »

Unidad de medida

La latencia se mide en milisegundos. Si tiene una cifra en milisegundos baja, la red solo está experimentando un pequeño retraso. Cuanto mayor sea la cifra en milisegundos, más lento será el rendimiento de la red.

Originalmente, se medía el rendimiento de la red en bits por segundo (bps). Sin embargo, a medida que las tecnologías de transmisión de datos han mejorado, ahora se pueden alcanzar valores mucho más altos. Gracias a esto, puede medir el rendimiento en kilobytes por segundo (Kbps), megabytes por segundo (Mbps) e incluso gigabytes por segundo (Gbps). Un byte equivale a ocho bits.

Factores que influyen: la latencia en comparación con el rendimiento

Hay diferentes factores que pueden afectar a las métricas de latencia y rendimiento.

Latencia

La latencia tiene varios factores que contribuyen a que sea alta o baja.

Ubicación

Uno de los factores más importantes es la ubicación donde se originan los datos y su destino previsto. Si sus servidores se encuentran en una región geográfica diferente a la de su dispositivo, los datos tienen que viajar más lejos, lo que aumenta la latencia. Este factor se denomina propagación.

Congestión de red

La congestión de red se produce cuando se transmite un gran volumen de datos a través de una red. El aumento del tráfico en la red hace que los paquetes tomen rutas más largas hasta su destino.

Eficiencia del protocolo

Algunas redes requieren protocolos adicionales de seguridad. Los pasos adicionales de los protocolos de enlace generan un retraso.

Infraestructura de red

Los dispositivos de red pueden sobrecargarse, lo que provoca la pérdida de paquetes. A medida que los paquetes se retrasan o se descartan, los dispositivos los retransmiten. Esto agrega latencia adicional.

Rendimiento

Las velocidades de rendimiento se ven directamente afectadas por otros factores.

Ancho de banda

Si la capacidad de su red ha alcanzado el ancho de banda máximo de su medio de transmisión, su rendimiento nunca podrá superar ese límite.

Gran potencia de procesamiento

Ciertos dispositivos de red cuentan con optimizaciones de hardware o software especializadas que mejoran su rendimiento de procesamiento. Algunos ejemplos son los circuitos integrados dedicados a aplicaciones específicas o los motores de procesamiento de paquetes basados en software.

Estas optimizaciones permiten al dispositivo gestionar mayores volúmenes de tráfico y tareas de procesamiento de paquetes más complejas, lo que se traduce en un mayor rendimiento.

Pérdida de paquetes

La pérdida de paquetes puede producirse por diversos motivos, como la congestión de la red, hardware defectuoso o dispositivos de red mal configurados. Cuando se pierden paquetes, deben volver a transmitirse. Esto provoca retrasos y reduce el rendimiento general de la red.

Topología de red

La topología de red hace referencia a la cantidad de dispositivos de red, el ancho de banda de los enlaces de red y la distancia entre los dispositivos de una ruta de red.

Una topología de red bien diseñada proporciona múltiples rutas para la transmisión de datos, reduce los atascos de tráfico y aumenta el rendimiento. Las redes con más dispositivos o distancias más largas requieren topologías de red complejas para lograr un alto rendimiento.

Relación entre ancho de banda, latencia y rendimiento

La latencia y el rendimiento se combinan para ofrecer un alto desempeño y conectividad de red. Como ambos tienen un efecto sobre la transmisión de paquetes de datos, también se afectan entre sí.

Si una conexión de red tiene una latencia alta, puede tener un rendimiento inferior, ya que los datos tardan más en transmitirse y llegar. El bajo rendimiento también hace que parezca que una red tiene una latencia alta, ya que tardan más en llegar grandes cantidades de datos.

Como están estrechamente vinculados, debe supervisar tanto la latencia como el rendimiento para lograr un alto rendimiento de la red.

Ancho de banda y rendimiento de red

El ancho de banda representa el volumen total de datos que puede transferir a través de una red. El ancho de banda total se refiere a la cantidad máxima teórica de datos que puede transferir a través de una red. Se mide en megabytes por segundo (Mbps). Puede pensar en el ancho de banda como el rendimiento máximo teórico de su red.

El ancho de banda es la cantidad de datos que puede transferir, mientras que el rendimiento es la cantidad real de datos que transmite en un momento dado en función de las limitaciones de la red del mundo real. Un ancho de banda alto no garantiza la velocidad ni un buen rendimiento de la red, pero un ancho de banda mayor se traduce en un mayor rendimiento.

¿Cómo puede mejorar la latencia y el rendimiento?

Para mejorar la latencia, puede acortar la propagación entre el origen y el destino. Puede mejorar el rendimiento si aumenta el ancho de banda general de la red.

A continuación, ofrecemos algunas sugerencias para mejorar conjuntamente la latencia y el rendimiento.

Almacenamiento en caché

En redes, el almacenamiento en caché se refiere al proceso de almacenar datos a los que se accede con frecuencia en una ubicación geográfica más cercana al usuario. Por ejemplo, puede almacenar datos en servidores proxy o redes de entrega de contenido (CDN).

Su red puede entregar datos desde la ubicación en caché mucho más rápido que si tuviera que recuperarlos de la fuente original. Además, el usuario recibe los datos mucho más rápido, lo que mejora la latencia. Por otra parte, dado que los datos se recuperan de una memoria caché, se reduce la carga en la fuente original. Esto le permite gestionar más solicitudes a la vez, lo que mejora el rendimiento.

Protocolos de transporte

Al optimizar el protocolo de transporte que utiliza para aplicaciones específicas, puede mejorar el rendimiento de la red.

Por ejemplo, TCP y UDP son dos protocolos de red comunes. TCP establece una conexión y comprueba que usted recibe los datos sin errores. Debido a su objetivo de reducir la pérdida de paquetes, TCP tiene una latencia y un rendimiento más altos. UDP no comprueba si hay errores o pérdidas de paquetes, sino que transmite varios paquetes duplicados. Por lo tanto, ofrece una latencia mínima pero un mayor rendimiento.

Según la aplicación que utilice, TCP o UDP pueden ser la mejor opción. Por ejemplo, TCP es útil para transferir datos, mientras que UDP es útil para streaming de video y videojuegos.

Calidad de servicio

Puede utilizar una estrategia de calidad de servicio (QoS) para gestionar y optimizar el rendimiento de la red. QoS permite dividir el tráfico de red en categorías específicas. Puede asignar un nivel de prioridad a cada categoría.

Sus configuraciones de QoS priorizan las aplicaciones sensibles a la latencia. Algunas aplicaciones y usuarios experimentan una latencia más baja que otros. Sus configuraciones de QoS también pueden priorizar los datos por tipo, lo que reduce la pérdida de paquetes y aumenta el rendimiento para ciertos usuarios

Resumen de las diferencias: rendimiento frente a latencia

| Desempeño |

Latencia |

|

| ¿Qué mide? |

El rendimiento mide el volumen de datos que pasan por una red en un período determinado. El rendimiento afecta a la cantidad de datos que puede transmitir en un período de tiempo. |

La latencia mide el tiempo de demora en el envío de datos. Una latencia más alta provoca un retraso en la red. |

| ¿Cómo se mide? |

Envíe un archivo o utilice herramientas de prueba de red para calcular el rendimiento de manera manual. |

Calcule la latencia mediante tiempos de ping. |

| Unidad de medida |

Megabytes por segundo (Mbps). |

Milisegundos (ms). |

| Factores que afectan |

Ancho de banda, potencia de procesamiento de red, pérdida de paquetes y topología de red. |

Distancias geográficas, congestión de red, protocolo de transporte e infraestructura de red. |

¿Cómo puede AWS satisfacer sus requisitos de rendimiento de red?

Amazon Web Services (AWS) cuenta con varias soluciones para reducir la latencia de la red y mejorar su rendimiento. Puede implementar cualquiera de los siguientes servicios, según sus necesidades:

- Amazon CloudFront es un servicio de red de entrega de contenido creado para ofrecer un alto rendimiento, seguridad y comodidad para los desarrolladores. Puede usarlo para entregar contenidos de forma segura con baja latencia y alta velocidad de transferencia.

- AWS Direct Connect es un servicio de nube que conecta las redes directamente a AWS para ofrecer una latencia inferior y más constante. Al crear una nueva conexión, puede elegir una conexión alojada proporcionada por un socio de entrega de AWS Direct Connect, u optar por una conexión exclusiva de AWS, y realizar el despliegue en más de 100 ubicaciones de AWS Direct Connect en todo el mundo.

- AWS Global Accelerator es un servicio de redes que mejora el rendimiento del tráfico de los usuarios hasta en un 60 % a través de la infraestructura global para redes de AWS. Cuando Internet se congestiona, AWS Global Accelerator optimiza la ruta de acceso a la aplicación para mantener un nivel bajo de pérdida de datos, fluctuaciones y latencia.

- Las zonas locales de AWS son un tipo de implementación de infraestructura que pone la computación, el almacenamiento, las bases de datos y otros servicios seleccionados de AWS al alcance de grandes centros urbanos e industriales. Puede ofrecer aplicaciones innovadoras que requieran una latencia baja más cerca de los usuarios finales y las instalaciones locales.

Para comenzar a optimizar el rendimiento y la latencia en AWS cree una cuenta hoy mismo.