Apa itu Amazon SageMaker Inference?

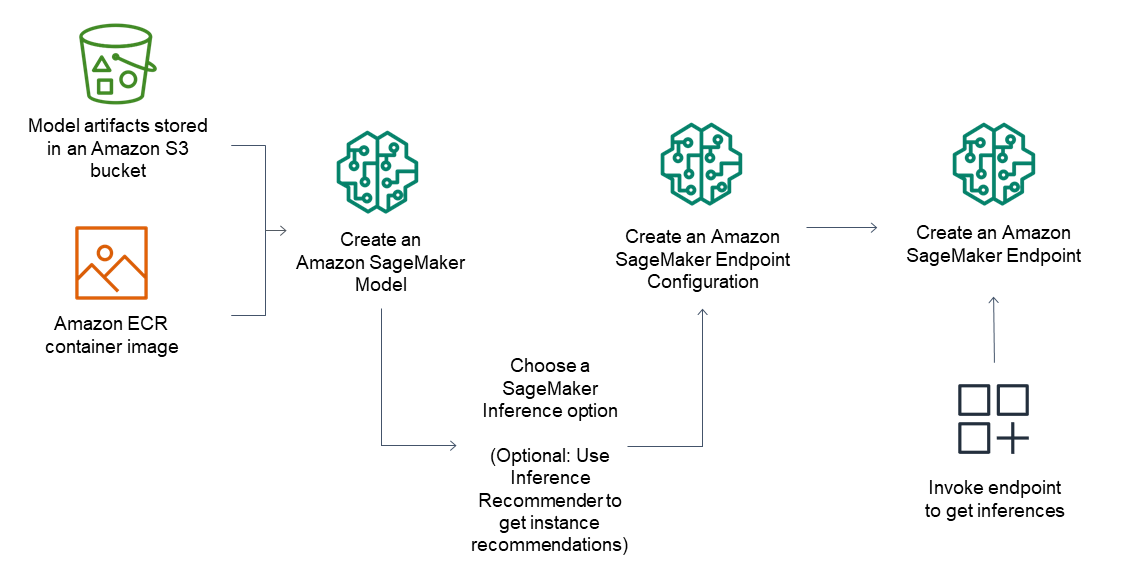

Amazon SageMaker AI memudahkan deployment model ML termasuk model fondasi (FM) untuk membuat permintaan inferensi dengan performa harga terbaik bagi setiap kasus penggunaan. Mulai dari latensi rendah dan throughput tinggi hingga inferensi jangka panjang, Anda dapat menggunakan SageMaker AI untuk semua kebutuhan inferensi. SageMaker AI adalah layanan terkelola penuh dan terintegrasi dengan alat MLOps, sehingga Anda dapat menskalakan deployment model, mengurangi biaya inferensi, mengelola model dengan lebih efektif dalam produksi, serta mengurangi beban operasional.

Manfaat SageMaker Inference

Berbagai opsi inferensi

Inferensi Waktu Nyata

Inferensi Nirserver

Inferensi Asinkron

Batch Transform

Opsi inferensi yang dapat diskalakan dan hemat biaya

Titik akhir model tunggal

Satu model pada konteiner yang di-hosting pada instans khusus atau nirserver untuk latensi rendah dan throughput tinggi.

Banyak model di satu titik akhir

Host beberapa model ke instans yang sama untuk memanfaatkan akselerator yang mendasarinya dengan lebih baik, sehingga mengurangi biaya deployment hingga 50%. Anda dapat mengontrol kebijakan penskalaan untuk setiap FM secara terpisah, sehingga lebih mudah untuk beradaptasi dengan pola penggunaan model sekaligus mengoptimalkan biaya infrastruktur.

Alur inferensi serial

Beberapa kontainer berbagi instans khusus dan melakukan eksekusi secara berurutan. Anda dapat menggunakan alur inferensi untuk menggabungkan tugas ilmu data prapemrosesan, prediksi, dan pascapemrosesan.

Dukungan untuk sebagian besar kerangka kerja machine learning dan server model

Inferensi Amazon SageMaker mendukung algoritma bawaan dan citra Docker bawaan untuk beberapa kerangka kerja machine learning yang paling umum, seperti TensorFlow, PyTorch, ONNX, dan XGBoost. Jika tidak ada citra Docker bawaan yang memenuhi kebutuhan Anda, Anda dapat membuat kontainer Anda sendiri untuk digunakan dengan titik akhir multimodel yang didukung CPU. Inferensi SageMaker mendukung server model paling populer, seperti TensorFlow Serving, TorchServe, NVIDIA Triton, dan server multimodel AWS.

Amazon SageMaker AI menawarkan kontainer deep learning (DLC) khusus, pustaka, dan alat untuk paralelisme model serta inferensi model besar (LMI) agar dapat membantu Anda meningkatkan performa model fondasi. Dengan opsi ini, Anda dapat men-deploy berbagai model, termasuk model fondasi (FM) dengan cepat untuk hampir semua kasus penggunaan.

Capai performa inferensi tinggi dengan biaya rendah

Capai performa inferensi tinggi dengan biaya rendah

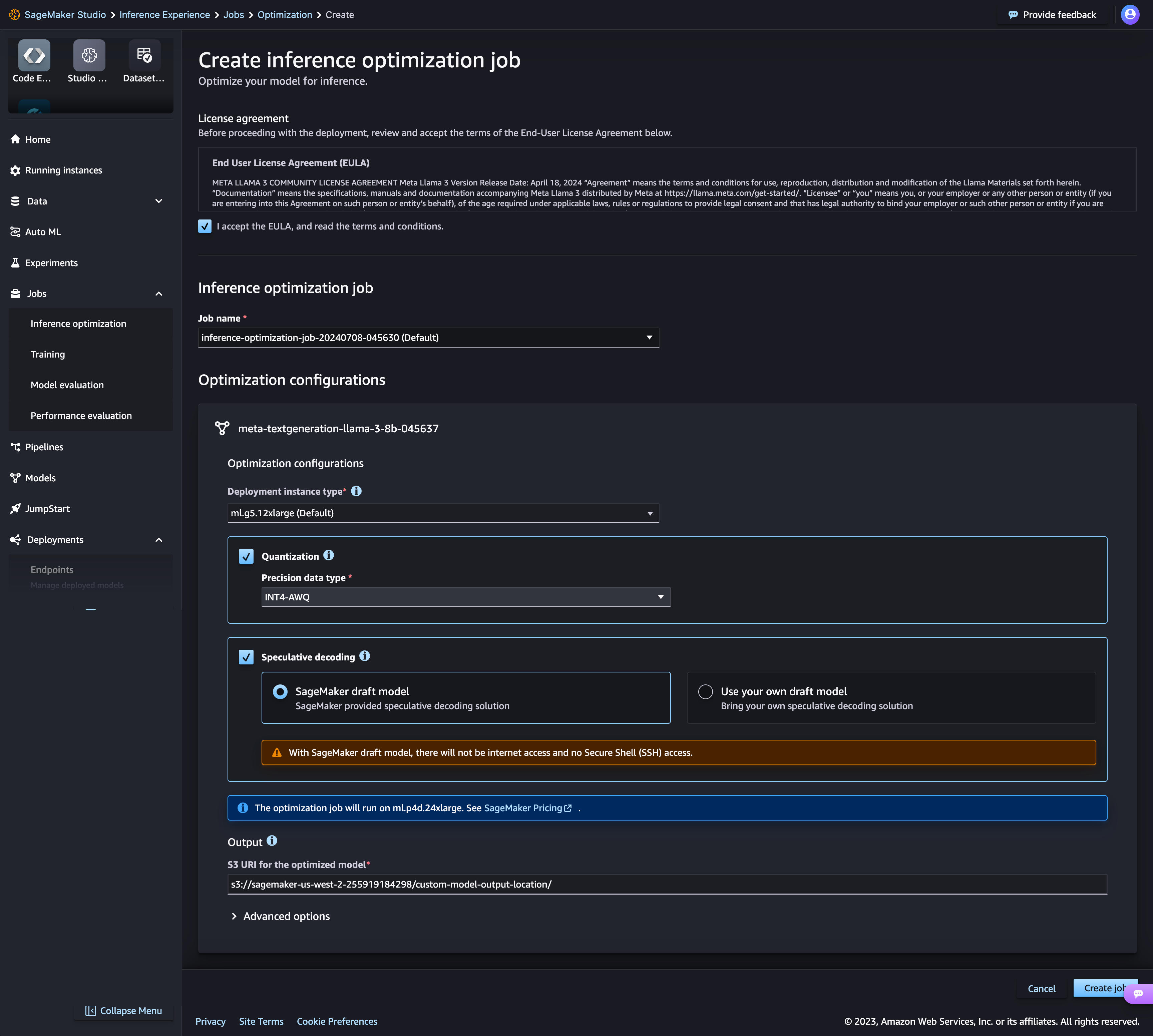

Kit alat optimisasi inferensi baru Amazon SageMaker AI menghadirkan throughput hingga ~2x lebih tinggi sekaligus mengurangi biaya hingga ~50% untuk model AI generatif, seperti model Llama 3, Mistral, dan Mixtral. Misalnya, dengan model Llama 3-70B, Anda dapat mencapai hingga ~2400 token/detik pada instans ml.p5.48xlarge v/s ~1200 token/detik sebelumnya tanpa optimisasi apa pun. Anda dapat memilih teknik optimisasi model, seperti Dekoding Spekulatif, Kuantisasi, dan Kompilasi atau menggabungkan beberapa teknik, menerapkannya ke model Anda, menjalankan tolok ukur untuk mengevaluasi dampak teknik pada kualitas output dan performa inferensi, serta melakukan deployment model hanya dalam beberapa klik.

Lakukan deployment model pada infrastruktur beperforma paling tinggi atau beroperasilah secara nirserver

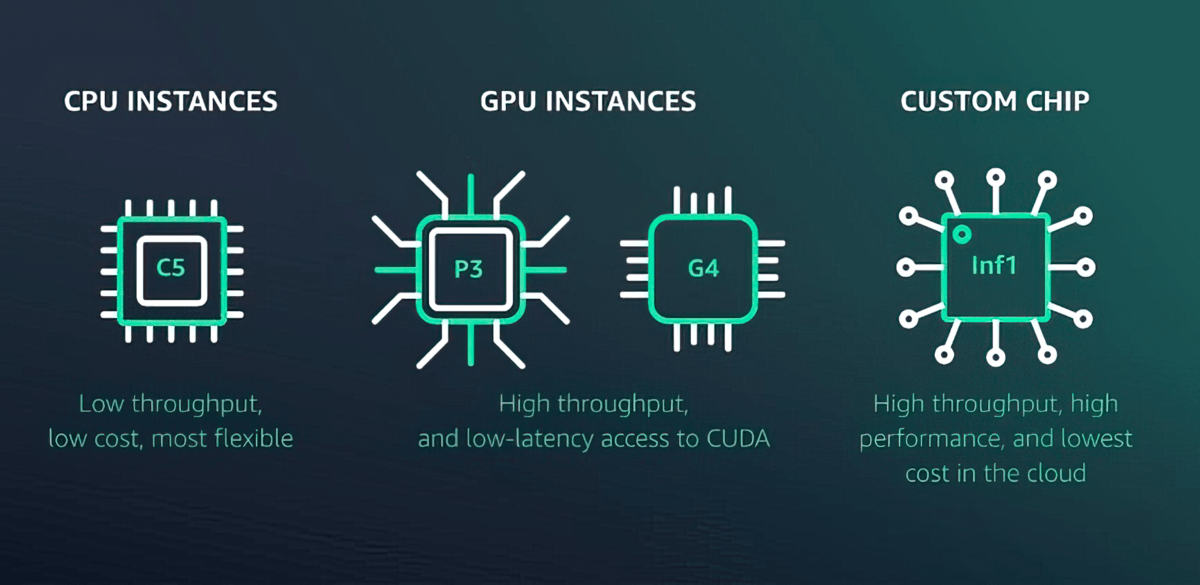

Amazon SageMaker AI menawarkan lebih dari 70 tipe instans dengan berbagai tingkat komputasi dan memori, termasuk instans Inf1 Amazon EC2 berbasis AWS Inferentia, cip inferensi ML performa tinggi yang didesain dan dibangun oleh AWS, serta instans GPU seperti G4dn Amazon EC2. Atau, pilih Inferensi Nirserver Amazon SageMaker untuk dengan mudah menskalakan ke ribuan model per titik akhir, jutaan throughput transaksi per detik (TPS), dan latensi biaya tambahan sub10 milidetik.

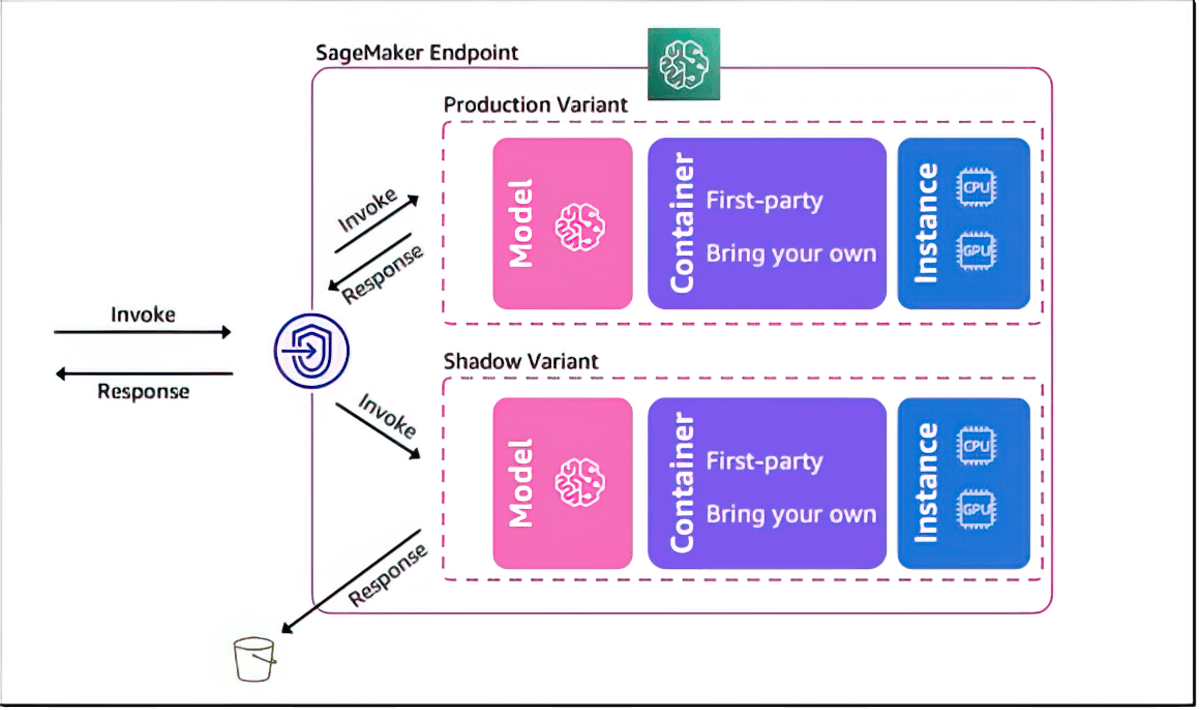

Uji bayangan untuk memvalidasi performa model ML

Amazon SageMaker AI membantu Anda mengevaluasi model baru dengan pengujian bayangan pada performanya terhadap model yang sedang di-deploy oleh SageMaker dengan menggunakan permintaan inferensi langsung. Pengujian bayangan dapat membantu Anda menangkap potensi kesalahan konfigurasi dan masalah performa sebelum berdampak pada pengguna akhir. Dengan SageMaker AI, Anda tidak perlu menginvestasikan waktu berminggu-minggu untuk membangun infrastruktur pengujian bayangan Anda sendiri. Anda hanya perlu memilih model produksi yang akan diuji dan SageMaker AI secara otomatis men-deploy model baru dalam mode bayangan serta merutekan salinan permintaan inferensi yang diterima oleh model produksi ke model baru dalam waktu nyata.

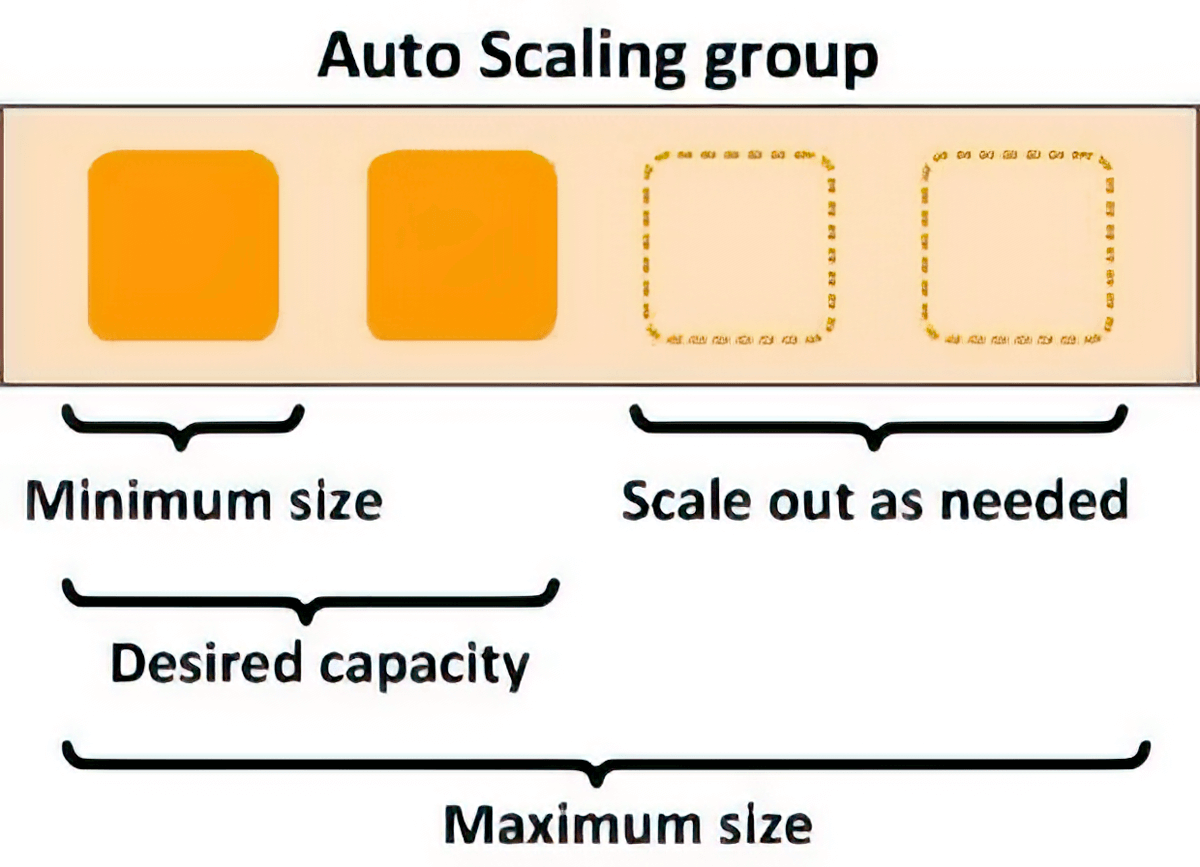

Penskalaan otomatis untuk elastisitas

Anda dapat menggunakan kebijakan penskalaan untuk secara otomatis menskalakan sumber daya komputasi yang mendasarinya guna mengakomodasi fluktuasi permintaan inferensi. Anda dapat mengontrol kebijakan penskalaan untuk setiap model ML secara terpisah guna menangani perubahan dalam penggunaan model dengan mudah, sekaligus mengoptimalkan biaya infrastruktur.

Peningkatan latensi dan perutean cerdas

Anda dapat mengurangi latensi inferensi untuk model ML dengan secara cerdas merutekan permintaan inferensi baru ke instans yang tersedia, alih-alih merutekan permintaan secara acak ke instans yang sudah sibuk melayani permintaan inferensi, sehingga memungkinkan Anda mencapai rata-rata latensi inferensi 20% lebih rendah.

Kurangi beban operasional dan percepat waktu penilaian

Hosting dan manajemen model yang terkelola penuh

Sebagai layanan terkelola penuh, Amazon SageMaker AI menangani pengaturan serta pengelolaan instans, kompatibilitas versi perangkat lunak, dan versi patching. Amazon SageMaker juga menyediakan metrik dan log bawaan untuk titik akhir yang dapat Anda gunakan guna memantau dan menerima peringatan.

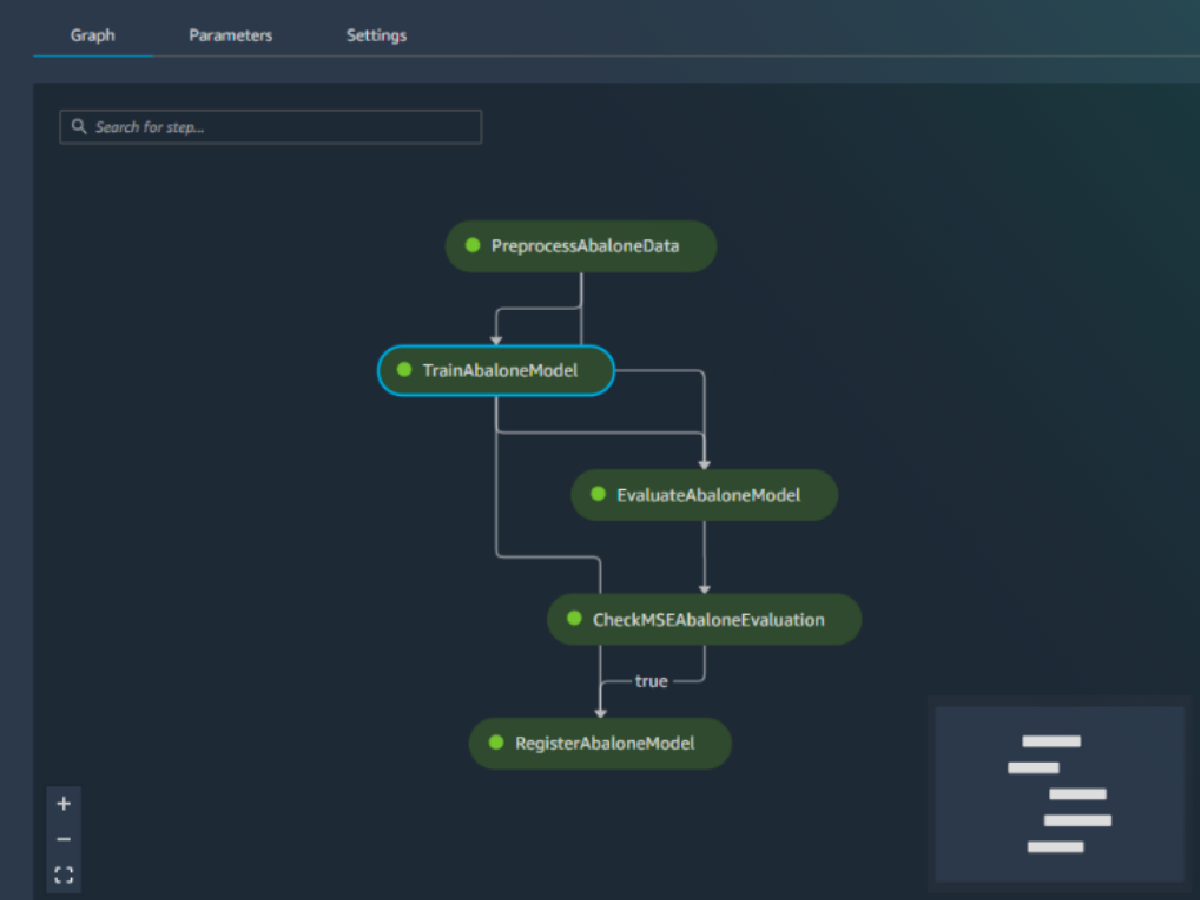

Integrasi bawaan dengan fitur MLOps

Fitur deployment model Amazon SageMaker AI terintegrasi secara native dengan kemampuan MLOps, termasuk SageMaker Pipelines (otomatisasi dan orkestrasi alur kerja), SageMaker Projects (CI/CD untuk ML), SageMaker Feature Store (manajemen fitur), SageMaker Model Registry (model dan katalog artefak untuk melacak silsilah dan mendukung alur kerja persetujuan otomatis), SageMaker Clarify (deteksi bias), dan SageMaker Model Monitor (deteksi penyimpangan model dan konsep). Oleh karena itu, baik Anda men-deploy satu atau puluhan ribu model, SageMaker AI membantu memindahkan overhead operasional dalam deployment, penskalaan, dan pengelolaan model ML, serta mempercepat proses produksi.