Instâncias Inf1 do Amazon EC2

Empresas de vários setores estão buscando transformação com tecnologia de inteligência artificial para orientar a inovação empresarial, aprimorar a experiência do cliente e processar melhorias. Os modelos de machine learning (ML) que alimentam as aplicações de IA estão se tornando cada vez mais complexos, resultando no aumento de custos de infraestrutura de computação básica. Muitas vezes, até 90% do gasto com infraestrutura para desenvolver e executar aplicações de ML é usado na inferência. Os clientes buscam por soluções de infraestrutura econômicas para implantar suas aplicações de ML na produção.

As instâncias Inf1 do Amazon EC2 oferecem inferência de ML de alta performance e baixo custo. Elas entregam um throughput até 2,3 vezes maior e um custo até 70% menor por inferência em comparação com as instâncias do Amazon EC2. As instâncias Inf1 são criadas do zero para dar suporte a aplicações de inferência de ML. Elas contam com até 16 chips AWS Inferentia, chips de ML de alta performance projetados e fabricados pela AWS. Além disso, as instâncias Inf1 incluem processadores Intel Xeon Scalable da segunda geração e redes de até 100 Gbps para entregar inferência com alto throughput.

Os clientes podem usar instâncias Inf1 para executar aplicações de inferência de ML em grande escala, como pesquisa, mecanismos de recomendação, visão computacional, reconhecimento de fala, processamento de linguagem natural (PLN), personalização e detecção de fraude.

Os desenvolvedores podem implantar seus modelos de ML em instâncias Inf1 usando o AWS Neuron SDK, que está integrada a frameworks conhecidos de ML, como TensorFlow, PyTorch e Apache MXNet. Eles podem continuar usando os mesmos fluxos de trabalho de ML e migrar aplicações sem interrupções para instâncias Inf1 com alterações mínimas no código e sem depender de soluções específicas de um fornecedor.

Comece facilmente com instâncias Inf1 usando o Amazon SageMaker, as AMIs de deep learning da AWS (DLAMI) que vêm pré-configuradas com o Neuron SDK, ou o Amazon Elastic Container Service (Amazon ECS) ou o Amazon Elastic Kubernetes Service (Amazon EKS) para aplicações de ML em contêineres.

Benefícios

Custo até 70% menor por inferência

Usando instâncias Inf1, os desenvolvedores podem reduzir significativamente o custo de suas implantações de produção de ML. A combinação de baixo custo e alto throughput das instâncias Inf1 fornecem um custo por inferência até 70% menor em comparação com às instâncias do Amazon EC2.

Facilidade de uso e portabilidade de código

O Neuron SDK está integrado a frameworks comuns de ML, como TensorFlow, PyTorch e MXNet. Os desenvolvedores podem continuar usando os mesmos fluxos de trabalho de ML e migrar sua aplicação sem interrupções para instâncias Inf1 com alterações mínimas no código. Assim eles têm liberdade para usar o framework de ML que preferirem e a plataforma de computação que melhor atenda a seus requisitos. Também podem utilizar as tecnologias mais recentes sem ficarem dependentes de soluções específicas de um fornecedor.

Throughput até 2,3 vezes maior

As instâncias Inf1 entregam throughput até 2,3 vezes maior em comparação com as instâncias do Amazon EC2. Os chips AWS Inferentia que viabilizam as instâncias Inf1 são otimizados para performance de inferência em lotes de tamanho pequeno, o que permite que as aplicações em tempo real maximizem a throughput e atendam aos requisitos de latência.

Latência extremamente baixa

Os chips AWS Inferentia são equipados com uma grande memória no chip que permite o armazenamento em cache de modelos de ML diretamente no próprio chip. É possível implantar seus modelos usando funcionalidades como o NeuronCore Pipeline, que elimina a necessidade de acessar recursos fora da memória. Com as instâncias Inf1, você pode implantar aplicações de inferência em tempo real a latências quase em tempo real sem afetar a largura de banda.

Suporte para vários modelos de ML e tipos de dados

As instâncias Inf1 oferecem suporte a muitas arquiteturas de modelagem de ML comumente usadas, como SSD, VGG e ResNext para reconhecimento/classificação de imagens, bem como Transformer e BERT para PLN. Além disso, o suporte para o repositório de modelos HuggingFace no Neuron oferece aos clientes a capacidade de compilar e executar a inferência facilmente usando modelos pré-treinados ou detalhadamente ajustados. Basta trocar uma única linha de código. Também há suporte para vários tipos de dados, incluindo BF16 e FP16 com precisão mista para vários modelos e necessidades de performance.

Atributos

Desenvolvido pelo AWS Inferentia

O AWS Inferentia é um chip de ML projetado pela AWS para fornecer alta performance com economia. Cada chip AWS Inferentia tem quatro NeuronCores de primeira geração e fornece até 128 operações tera por segundo (TOPS) de performance, além de suporte para tipos de dados FP16, BF16 e INT8. Os chips AWS Inferentia apresentam uma grande memória interna que pode ser usada para armazenar grandes modelos em cache, o que é especialmente vantajoso para modelos que exigem acesso frequente à memória.

Implemente com estruturas de trabalho de ML conhecidas usando o AWS Neuron

O SDK do AWS Neuron consiste em um compilador, driver de runtime e ferramentas de criação de perfil. Ele permite a implantação de modelos complexos de redes neurais, criados e treinados em estruturas de trabalho populares, como TensorFlow, PyTorch e MXNet, para serem executados usando instâncias Inf1. Com o NeuronCore Pipeline, você pode dividir modelos grandes para execução em vários chips Inferentia usando uma interconexão física entre chips de alta velocidade, gerando alto throughput de inferência e custos de inferência reduzidos.

Rede e armazenamento de alta performance

As instâncias Inf1 oferecem até 100 Gbps de throughput de rede para aplicações que requerem acesso a rede de alta velocidade. A tecnologia de última geração do Adaptador de Rede Elástica (ENA) e do NVM Express (NVMe) proporciona instâncias Inf1 com alto throughput e interfaces de baixa latência para redes e para o Amazon Elastic Block Store (Amazon EBS).

Baseadas no AWS Nitro System

O AWS Nitro System é uma coleção sofisticada de blocos de criação que transferem muitas das funções tradicionais de virtualização para hardware e software dedicados para entregar altos níveis de performance, disponibilidade e segurança, além de reduzir a sobrecarga da virtualização.

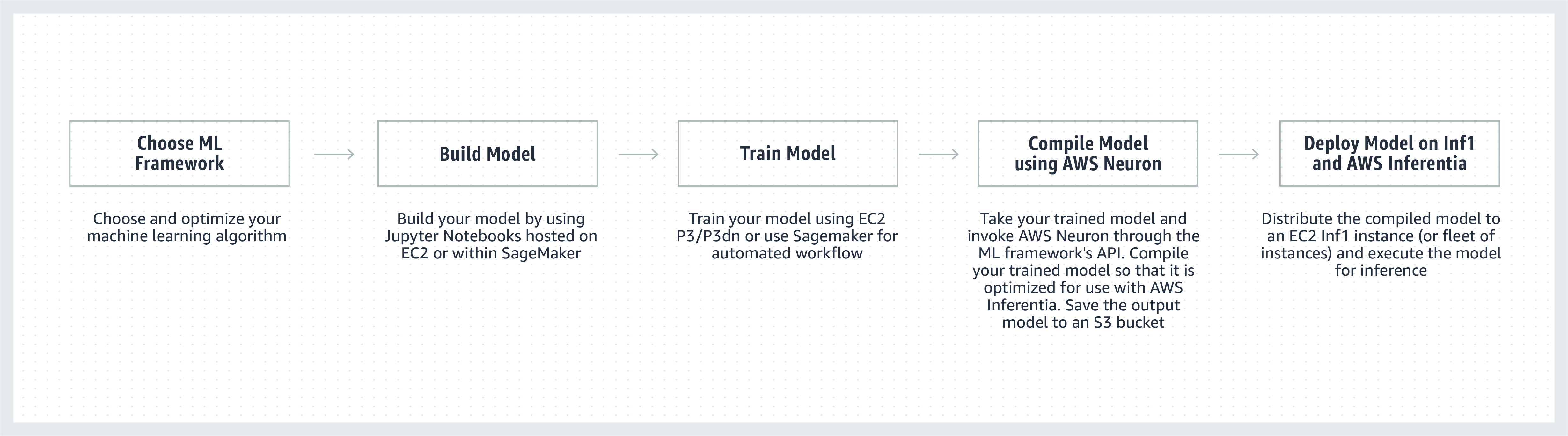

Como funciona

Depoimentos de clientes

“Incorporamos ML a vários aspectos do Snapchat, e explorar a inovação nesta área é uma prioridade importantíssima. Depois que conhecemos o Inferentia, começamos a colaborar com a AWS para adotar instâncias Inf1/Inferentia para nos ajudar com a implantação de ML, inclusive sobre performance e custo. Começamos com nossos modelos de recomendação e estamos ansiosos para adotar mais modelos com as instâncias Inf1 no futuro.”

Nima Khajehnouri, vice-presidente de engenharia da Snap Inc.

"A plataforma Unified Customer Experience Management orientada por IA da Sprinklr (Unified-CXM) permite que as empresas coletem e traduzam o feedback do cliente em tempo real por meio de vários canais em insights acionáveis. Isso resulta em resolução proativa de problemas, aperfeiçoamento do desenvolvimento de produtos, aprimoramento do marketing de conteúdo, melhor atendimento ao cliente e muito mais. Com a instância Inf1 do Amazon EC2, conseguimos melhorar significativamente a performance de um de nossos modelos de PLN e melhorar a performance de um de nossos modelos de visão computacional. Estamos ansiosos para continuar usando a instância Inf1 do Amazon EC2 para melhor atender nossos clientes globais.”

Vasant Srinivasan, VP sênior de engenharia de produto, Sprinklr

“Nosso produto de PLN de última geração, Finch for Text, oferece aos usuários recursos para extrair, clarificar e aperfeiçoar vários tipos de entidades em grandes volumes de texto. A Finch for Text requer recursos de computação significativos para fornecer aos seus clientes aperfeiçoamentos de baixa latência em alimentações de dados globais. Atualmente, estamos usando instâncias Inf1 da AWS em nos nossos modelos de NLP do PyTorch, de tradução e de desambiguação de entidade. Podemos reduzir nossos custos de inferência em mais de 80% (pelas GPUs) com otimizações mínimas, enquanto mantemos a velocidade e a performance da inferência. Esse aperfeiçoamento permite que nossos clientes aprimorem seus textos nos idiomas francês, espanhol, alemão e holandês em tempo real nas alimentações de dados por streaming em uma escala global, o que é essencial para nossos serviços financeiros, para o agregador de dados e para nossos clientes do setor público.”

Scott Lightner, diretor de tecnologia da Finch Computing

“Alertamos sobre vários tipos de eventos em todo o mundo em vários idiomas, em diferentes formatos (imagens, vídeo, áudio, sensores de texto, combinações de todos esses tipos) de centenas de milhares de fontes. Otimizar a velocidade e o custo, considerando essa escala, é absolutamente essencial para nossos negócios. Com o AWS Inferentia, reduzimos a latência do modelo e alcançamos um throughput até nove vezes melhor por dólar. Isso nos permitiu aumentar a precisão do modelo e aumentar os recursos de nossa plataforma implantando modelos de DL mais sofisticados e processando 5 vezes mais volume de dados, mantendo nossos custos sob controle.”

Alex Jaimes, cientista-chefe e vice-presidente sênior de IA da Dataminr

“O Autodesk está aprimorando a tecnologia cognitiva do nosso assistente virtual baseado em IA, o Autodesk Virtual Agent (AVA), com o uso do Inferentia. O AVA responde a mais de 100.000 perguntas de clientes por mês empregando técnicas de Natural Language Understanding (NLU – Compreensão da linguagem natural) e de Deep Learning (DL – Aprendizado profundo) para extrair o contexto, a finalidade e o significado das consultas. No projeto piloto do Inferentia, conseguimos alcançar throughputs 4,9 vezes superiores em relação ao G4dn para nossos modelos de NLU, e não vemos a hora de executar mais workloads nas instâncias Inf1 baseadas no Inferentia.”

Binghui Ouyang, Cientista de dados sênior, Autodesk

Serviços da Amazon que usam instâncias Inf1 do Amazon EC2

O Amazon Advertising ajuda negócios de todos os tamanhos a se conectarem com seus clientes em todos os estágios da jornada de compra. Milhões de anúncios, incluindo texto e imagens, são moderados, classificados e oferecidos para uma experiência ideal do cliente diariamente.

“Para nosso processamento de anúncios em texto, implantamos modelos BERT baseados em PyTorch globalmente no AWS Inferentia baseado em instâncias Inf1. Ao mover dos GPUs para o Inferentia conseguimos reduzir nosso custo em 69% com performance comparável. Levamos menos de três semanas para compilar e testar nossos modelos para o AWS Inferentia. Ao usar o Amazon SageMaker para implantar nossos modelos para instâncias Inf1 garantimos que nossa implantação fosse escalável e fácil de gerenciar. Quando analisei pela primeira vez os modelos compilados, a performance com o AWS Inferentia foi tão impressionante que não precisei de executar novamente as avaliações para assegurar que estavam corretos! Daqui para frente, planejamos migrar nossos modelos de processamento de anúncios em imagem para o Inferentia. Já avaliamos e observamos uma latência 30% menor e uma economia de custo de 71% em relação a instâncias comparáveis baseadas em GPU para esses modelos.”

Yashal Kanungo, cientista aplicada, Amazon Advertising

Leia o blog de notícias »

“A IA e a inteligência baseada em ML do Amazon Alexa, desenvolvidas com a tecnologia AWS, estão disponíveis hoje em mais de 100 milhões de dispositivos, e nossa promessa para os clientes é que a Alexa ficará cada vez mais inteligente, mais conversacional, mais proativa e até mesmo mais prazerosa. O cumprimento dessa promessa requer aperfeiçoamentos contínuos nos tempos de resposta e nos custos de infraestrutura de ML, que é a razão pela qual estamos muito satisfeitos com o uso de instâncias Inf1 do Amazon EC2 para reduzir a latência de inferência e o custo por inferência no recurso de conversão de texto em fala da Alexa. Com as instâncias Inf1 do Amazon EC2, poderemos melhorar o serviço ainda mais para as dezenas de milhões de clientes que usam a Alexa todos os meses.”

Tom Taylor, vice-presidente sênior, Amazon Alexa

“Estamos inovando constantemente para aperfeiçoar nossa experiência do cliente e reduzir nossos custos de infraestrutura. Mudar nossas workloads de perguntas e respostas baseadas na Web (WBQA) de instâncias P3 baseadas em GPU para instâncias Inf1 baseadas no AWS Inferentia não só nos ajudou a reduzir custos de inferência em 60%, como também melhorou a latência ponta a ponta em mais de 40%, ajudando a melhorar a experiência de perguntas e respostas do cliente com a Alexa. Usar o Amazon SageMaker para nosso modelo baseado em TensorFlow tornou o processo de troca para instâncias Inf1 simples e fácil de gerenciar. Agora estamos usando instâncias Inf1 globalmente para executar essas workloads de WBQA, além de otimizar a performance dessas instâncias no AWS Inferentia para reduzir ainda mais o custo e a latência.”

Eric Lind, engenheiro de desenvolvimento de software, Alexa AI

“O Amazon Prime Video usa modelos de ML de visão computacional para analisar a qualidade dos vídeos de eventos ao vivo, a fim de garantir uma ótima experiência aos expectadores membros do Prime Video. Implantamos nossos modelos de ML para a classificação de imagens nas instâncias Inf1 do EC2 e a performance melhorou 4 vezes mais, além de observarmos uma redução de até 40% dos custos. Estamos tentando usar essas economias para inovar e criar modelos avançados, que possam detectar defeitos mais complexos, como intervalos de sincronização entre arquivos de áudio e vídeo para promover uma experiência de visualização aprimorada para os membros do Prime Video.”

Victor Antonino, Arquiteto de soluções da Amazon Prime Video

"O Amazon Rekognition é uma aplicação descomplicada de análise de vídeo e imagem que ajuda os clientes a identificar objetos, pessoas, texto e atividades. O Amazon Rekognition precisa de uma infraestrutura de DL de alta performance que seja capaz de analisar bilhões de imagens e vídeos diariamente para os nossos clientes. Com as instâncias Inf1 baseadas no AWS Inferentia, executar modelos do Amazon Rekognition, como classificação de objetos, resultou em latência oito vezes menor e throughput duas vezes maior em comparação com a execução desses modelos em GPUs. Com base nesses resultados, estamos migrando o Amazon Rekognition para Inf1, permitindo que nossos clientes recebam resultados precisos com mais rapidez.”

Rajneesh Singh, diretor de engenharia de software do Amazon Rekognition e Video

Definição de preço

*Os preços mostrados são para a região Leste dos EUA (Norte da Virgínia) da AWS. Os preços das instâncias reservadas para 1 e 3 anos são para as opções de pagamento “pagamento adiantado parcial” ou para as opções de pagamento "sem pagamento adiantado" de instâncias que não têm a opção “adiantado parcial”.

As instâncias Inf1 do Amazon EC2 estão disponíveis nas regiões da AWS Leste dos EUA (Norte da Virgínia) e Oeste dos EUA (Oregon) como instâncias sob demanda, reservadas ou spot.

Conceitos básicos

Usar o Amazon SageMaker

O SageMaker facilita a compilação e implantação de seu modelo de ML treinado na produção em instâncias Inf1 da Amazon para que você possa começar a gerar previsões em tempo real com baixa latência. O AWS Neuron, o compilador do AWS Inferentia, é integrado ao Amazon SageMaker Neo, ajudando você a compilar seus modelos de ML treinados para serem executados em instâncias Inf1 de maneira ideal. Com o SageMaker, você pode executar com facilidade seus modelos em clusters de escalabilidade automática de instâncias Inf1, distribuídos em várias zonas de disponibilidade, para entregar inferência em tempo real de alta performance e alta disponibilidade. Saiba como implantar no Inf1 usando o SageMaker com exemplos no GitHub.

Usar o DLAMI

A DLAMI disponibiliza a profissionais e pesquisadores de ML a infraestrutura e as ferramentas necessárias para acelerar o DL na nuvem em qualquer escala. O SDK do AWS Neuron vem pré-instalado no DLAMI para compilar e executar seus modelos de ML de forma otimizada em instâncias Inf1. Para obter orientações sobre como começar a usar, acesse oguia de seleção de AMIs e mais recursos de DL. Consulte o guia de Conceitos básicos do AWS DLAMI para aprender a usar o DLAMI com o Neuron.

Usar contêineres do Deep Learning

Os desenvolvedores agora podem implantar instâncias Inf1 no Amazon EKS, que é um serviço Kubernetes totalmente gerenciado, bem como no Amazon ECS, que é um serviço de orquestração de contêineres totalmente gerenciado da Amazon. Saiba mais sobre como começar a usar as instâncias Inf1 no Amazon EKS ou com o Amazon ECS. Mais detalhes sobre a execução de contêineres em instâncias Inf1 estão disponíveis na página do tutorial de ferramentas de contêiner do Neuron. O Neuron também está disponível pré-instalado nos contêineres de aprendizado profundo da AWS.

Blogs e artigos

How Amazon Search reduced ML inference costs by 85% with AWS Inferentia

por João Moura, Jason Carlson, Jaspreet Singh, Shaohui Xi, Shruti Koparkar, Haowei Sun, Weiqi Zhang e Zhuoqi Zhangs, 22/9/2022

por MIT Technology Review Inisghts, 01/11/2021

Choose the best AI accelerator and model compilation for computer vision inference with Amazon SageMaker (Escolher a melhor compilação de modelos e aceleradores de IA para a interface de visão computacional com o Amazon SageMaker)

por Davide Galliteli e Hasan Poonawala, 19/10/2021

Machine learning in the cloud is helping businesses innovate (Empresas estão inovando na nuvem com ajuda do machine learning)

por MIT Technology Review Insights, 15/10/2021

Serve 3,000 deep learning models on Amazon EKS with AWS Inferentia for under $50 an hour (Disponibilizar 3.000 modelo de aprendizado profundo no Amazon EKS com AWS Inferentia por menos de USD 50 a hora)

por Alex Iankoulski, Joshua Correa, Mahadevan Balasubramaniam e Sundar Ranganatha, 30/09/2021

Achieve 12x higher throughput and lowest latency for PyTorch Natural Language Processing applications out-of-the-box on AWS Inferentia (Alcançar uma taxa de transferência 12 vezes maior e a mais baixa latência para aplicações de Processamento de linguagem natural prontas para uso no AWS Inferentia)

por Fabio Nonato de Paula e Mahadevan Balasubramaniam, 04/05/2021

How We Used AWS Inferentia to Boost PyTorch NLP Model Performance by 4.9x for the Autodesk Ava Chatbot (Como usamos o AWS Inferentia para impulsionar a performance do modelo de NLP em PyTorch em 4,9 vezes o Autodesk Ava Chatbot)

por Binghui Ouyang, 07/04/2021

A maior parte da Alexa agora é executada em instâncias Inf1 do Amazon EC2 mais rápidas e econômicas

por Sébastien Stormacq, 12/11/2020

Announcing availability of Inf1 instances in Amazon SageMaker for high performance and cost-effective machine learning inference (Anúncio da disponibilidade de instâncias Inf1 no Amazon SageMaker para inferência de machine learning de alta performance e economia)

por Julien Simon, 22/04/2020

Amazon ECS Now Supports EC2 Inf1 Instances (Agora o Amazon ECS é compatível com instâncias Inf1 do EC2)

por Julien Simon, 14/08/2020

Por Fabio Nonato De Paula e Haichen Li, 22/07/2020

Agora Amazon EKS oferece suporte a instâncias Inf1 do EC2

por Julien Simon, 15/06/2020