Elastic Fabric Adapter (EFA) 是 Amazon EC2 執行個體適用的網路介面,可讓客戶在 AWS 上大規模執行需要高層級節點間通訊的應用程式。其客製化的作業系統 (OS) 略過硬體介面,可提升執行個體間通訊的效能,這對於擴充這些應用程式至關重要。有了 EFA,使用訊息傳遞界面 (MPI) 的高效能運算 (HPC) 應用程式和使用 NVIDIA Collective Communications Library (NCCL) 的機器學習 (ML) 應用程式都可以擴展至數千個 CPU 或 GPU。因此,您可以獲得內部部署 HPC 叢集的應用程式效能,還有 AWS 雲端的隨需彈性和靈活性。

EFA 可作為選用 EC2 聯網功能,您可以在任何支援的 EC2 執行個體上啟用,無需額外費用。此外,它還和最常用於節點間通訊的介面、API 和程式庫相容,因此您幾乎 (甚至完全) 無需對您的 HPC 應用程式進行任何修改,即可將其遷移到 AWS。

優勢

更快得到結果

EFA 的獨特 OS 略過聯網機制為執行個體間的通訊提供了一條低延遲、低抖動通道。這讓您緊密耦合的 HPC 或分散式機器學習應用程式能夠擴展到數千個核心,提升應用程式的執行速度。

具有靈活的組態

您可以在不斷增長的 EC2 執行個體清單上啟用 EFA 支援,並靈活地為您的工作負載選擇適當的運算組態。只要隨需求變化改變您的叢集組態即可,也可以在新的運算執行個體上啟用 EFA 支援。無需事先保留或前期規劃。

無縫遷移

EFA 使用 Libfabric 介面和 Libfabric API 進行通訊。由於幾乎所有的 HPC 程式設計模型都支援此介面,所以您可以將現有 HPC 應用程式遷移到雲端,只需少許修改,甚至無需任何修改。

EFA 效能

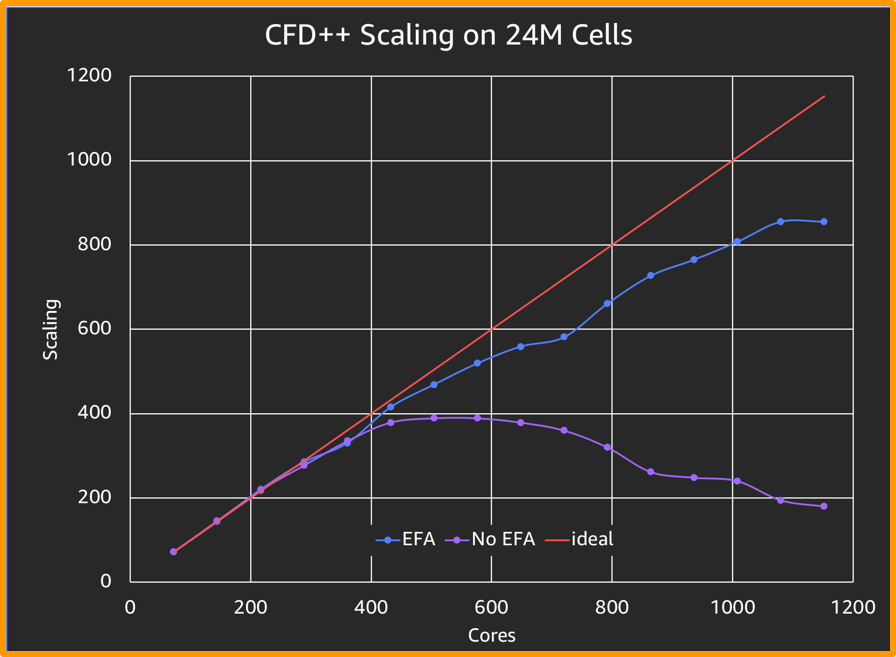

與使用 ENA 進行標準 CFD 模擬相比,EFA 可在擴展方面提供 4 倍於前者的改進,如上圖所示。

此基準測試的求解器由 Metacomp Technologies 提供

運作方式

使用案例

計算流體動力學

計算流動動力學 (CFD) 演算法的進步讓工程師能夠模擬愈加複雜的流體現象,而 HPC 則有助於縮短周轉時間。藉助 EFA,設計工程師現在可擴展其模擬工作,以試驗更多可調校的參數,從而更快取得更準確的結果。

天氣建模

複雜的天氣模型需要高記憶體頻寬、快速互連和穩健的平行檔案系統,以產生準確的結果。模型上的網格間隔越小,結果便越準確,模型所需的運算資源就越多。憑藉 EFA 所提供的快速互連,天氣建模應用程式可利用幾乎無限制的 AWS 雲端擴展能力,在更短時間內產生更準確的預測。

機器學習

GPU 上的分散式運算可大幅加快深度學習模型的訓練速度。領先的深度學習架構 (如 Caffe、Caffe2、Chainer、MxNet、TensorFlow 和 PyTorch) 整合了 NCCL,以便利用其多個節點之間的多 GPU 集合通訊。EFA 針對 AWS 上的 NCCL 進行了最佳化,改善了這些訓練模型的輸送量和可擴展性,從而可更快取得結果。

資源