什麼是 RLHF?

基於人類反饋的強化學習 (RLHF) 是一種機器學習 (ML) 技術,使用人類反饋來完善 ML 模型,以提升自學效率。強化學習 (RL) 技術訓練軟體做出最大化獎勵的決策,使其成果更加準確。RLHF 將人類反饋納入獎勵功能,使得 ML 模型執行任務時能夠更符合人類的目標,期望和需求。RLHF 被廣泛使用於生成式人工智慧(生成式 AI)應用,包括大型語言模型 (LLM) 在內。

為什麼 RLHF 很重要?

人工智慧 (AI) 的應用範圍相當廣泛,從自動駕駛汽車到自然語言處理 (NLP)、股市預測和零售個人化服務,不一而足。無論應用領域為何,AI 的最終目標都是模仿人類反應、行為和決策。ML 模型必須將人類輸入的內容編碼為訓練資料,以便 AI 進行複雜任務時更能精準效仿人類。

RLHF 是用於訓練 AI 系統的特定技術,使其顯得更人性化,並輔以其他技術,例如監督式與非監督式學習。首先,模型的回應會與人類答案進行比較。接著,人類訓練師評估機器不同回應的品質,根據其人性化程度給予評分。得分依據可以是人類的天生特質,例如友善程度、在情境中是否得體和情緒等。

RLHF 在自然語言理解的表現格外突出,但也應用於其他領域的生成式 AI。

提升 AI 效能

RLHF 可使 ML 模型更加精準。可根據預先產出的人工資料訓練模型,但額外的人類意見回饋迴圈,可顯著提升模型與其初始狀態相比的性能。

例如,將文本從一種語言翻譯成另一種語言時,模型可能會產生技術上正確的文字,但讀者聽起來並不自然。專業譯者可先完成翻譯,再將機器生成的翻譯與之對照,進行評分,接著便可針對一系列機器生成的翻譯品質給分。進一步訓練模型,可幫助模型產出聽起來更自然的翻譯。

導入複雜的訓練參數

在生成式 AI 的部分範例中,可能難以針對特定參數準確訓練模型。例如,您要怎麼定義一首樂曲的氛圍? 音調和節奏等技術參數或許能表現特定氛圍,但比起一系列技術指標,音樂作品的精神更為主觀,定義也更加不清。您不妨改為提供人工指導,由作曲家創作曲調憂鬱的作品,再根據機器生成作品的感性程度進行標示。機器便能更迅速地學會這些參數。

提高用戶滿意度

雖然 ML 模型可能不失精準,卻很可能少了人性。因此需要 RL 來引導模型,產生最適合人類使用者、最討人喜歡的回應。

例如,如果您詢問聊天機器人戶外天氣如何,它可能會回答:「氣溫攝氏 30 度,有雲、濕度很高。」或者可能是:「目前氣溫約為 30 度。多雲、潮濕,因此可能感覺比較悶!」儘管兩個答案表達相同內容,但第二個答案聽起來更自然,也提供更多脈絡。

當人類使用者為喜愛的模型答案評分時,您可運用 RLHF 收集意見並改進模型,讓模型能以最佳方式為現實生活中的人們提供服務。

RLHF 如何運作?

在判定模型就緒之前,RLHF 以四個階段執行。我們在此以語言模型(內部公司知識庫聊天機器人)為例,該模型使用 RLHF 進行改善。

我們只大致描述學習過程。訓練模型並透過 RLHF 改善原理,牽涉十分複雜的數理計算。然而,RLHF 已完善定義複雜的算式,且通常已預先內建演算法,您只須輸入獨有的內容。

資料收集

在使用語言模型執行 ML 任務之前,會先針對訓練資料建立一組人工產出的提示和回應。這組資料稍後會用於模型的訓練過程。

例如,提示可能是:

- 「人力資源部門在波士頓的哪裡?」

- 「社群媒體貼文的核准流程為何?」

- 「與之前的季度報告相比,第一季報告顯示出哪些業績資訊?」

接著,公司的資深員工針對這些問題提供自然的正確答案。

監督語言模型的微調

您可使用預先訓練的商業模型作為 RLHF 的基礎模型。您可運用檢索增強生成 (RAG) 等技術,根據公司內部知識庫微調模型。模型微調後,您可以將其回應預先定義之提示的結果,與上一步驟收集的人工答案進行比較。兩者之間的相似程度可透過數理計算。

例如,機器產生的回應可取得介於 0 到 1 之間的分數,1 代表最準確,0 則表示最不準確。有了這些分數,如今該模型的設計方針之一,便是取得與人工答案接近的得分。這項方針構成該模型未來所有決策的基礎。

建立單獨的獎勵模型

RLHF 的核心在於,根據人類意見回饋訓練單獨的 AI 獎勵模型,再將此模型作為獎勵函數,透過 RL 進行最佳化。由於模型回應同一提示時會出現多組答案,人類可根據每一答案的品質表達喜好。您可運用這些回應評分偏好建立獎勵模型,該模型會自動估計人類針對任何特定回應的給分高低。

透過以獎勵為基礎的模型,將語言模型最佳化

接著,語言模型即可使用獎勵模型,在回應提示前自動調整其策略。語言模型會運用獎勵模型,在內部評估一系列回應,然後選擇最可能得到最大獎勵的答案。這表示模型能以最佳化的方式滿足人類偏好。

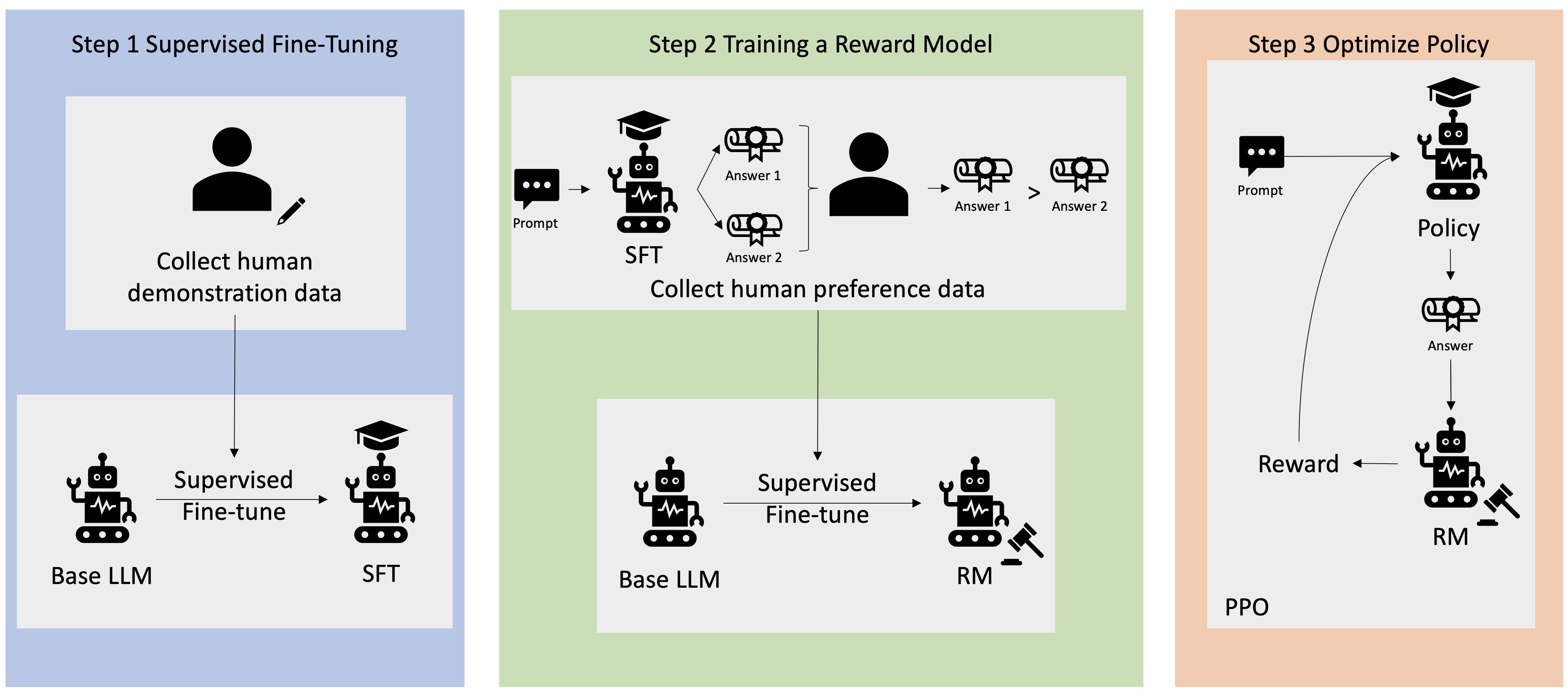

下圖簡要說明 RLHF 的學習過程。

RLHF 如何運用於生成式 AI 領域?

一般認為 RLHF 是業界標準技術,確保 LLM 產出真實、無害和實用的內容。然而,人類溝通是主觀和充滿創意的過程,LLM 輸出成果的實用程度也深受人類價值觀和喜好的影響。每個模型的訓練方式皆略有差異,並由不同人類訓練師提供回應,因此即使在競爭激烈的 LLM 之間,輸出結果也有所不同。每個模型涉及人類價值觀的程度完全取決於創作者。

RLHF 的應用超越 LLM 界限,拓展到其他類型的生成式 AI。以下是一些範例:

- RLHF 可用於 AI 圖像生成:例如判斷藝術作品的逼真度、技巧或基調。

- 音樂生成方面,RLHF 可協助創作符合特定活動氣氛和配樂的音樂

- RLHF 可用於語音助理,引導聲音聽起來更友善、表現出好奇且值得信賴

AWS 如何協助滿足您的 RLHF 需求?

Amazon SageMaker Ground Truth 提供最全面的人機共學功能,在整個機器學習週期中整合人類意見回饋,藉以改善模型準確度與關聯性。您可透過自助或 AWS 管理服務完成各種人機共學任務,從資料生成和註釋到獎勵模型生成、模型審查和客製化。

SageMaker Ground Truth 包含提供 RLHF 功能的資料註解程式。您可針對模型對 RL 結果的回應進行排名、分類或雙管齊下,對模型生成的輸出結果提供直接意見回饋與指導。這些資料稱為比較和排名資料,實際上是獎勵模型或獎勵功能,隨後可用於訓練模型。您可以運用比較和排名資料,針對使用案例自訂現有模型,或微調從頭開始建立的模型。

立即建立帳戶,開始在 AWS 上使用 RLHF 技術。